Какой взрослый не мечтал в детстве, чтобы с любимой игрушкой можно было поговорить по-настоящему? Если для нас подобные мечты были лишь невинными фантазиями, которые развивали воображение, то для современных детей они очень быстро становятся реальностью.

К примеру, в июне этого года один из крупнейших производителей детских игрушек — создавшая культовую куклу Барби компания Mattel — сообщила о начале сотрудничества с OpenAI для разработки ИИ-кукол. Однако Mattel станет не первой компанией, воплощающей в жизнь идею умных говорящих игрушек. Многие производители уже активно выпускают игрушечных ИИ-компаньонов для детей. В этом посте мы поговорим о том, как работают подобные игрушки, и изучим риски, связанные с их использованием.

Что представляют собой ИИ-игрушки

Под ИИ-игрушками в данном случае мы будем подразумевать настоящие физические игрушки, а не программы или приложения. На сегодняшний день искусственный интеллект чаще всего встраивают в мягкие игрушки или детских роботов. Такие игрушки способны вести с ребенком осмысленные развернутые беседы благодаря интеграции с большими языковыми моделями.

Многие пользователи современных чат-ботов знают, что ИИ можно попросить сыграть любую роль: от персонажа книги или фильма до диетолога или эксперта по кибербезопасности. Как отмечают авторы исследования ИИ приходит в детскую: искусственные компаньоны и реальные риски, подготовленного Образовательным фондом U.S. PIRG, в случае с ИИ-игрушками производители изначально задают для них роль лучшего друга для ребенка.

Примеры ИИ-игрушек, протестированных в исследовании: плюшевые компаньоны и детские роботы со встроенными языковыми моделями. Источник

Важно отметить, что в основе таких игрушек не лежит какой-то особенный специализированный «детский ИИ». На своих сайтах их создатели говорят об использовании популярных моделей, которые многим уже прекрасно знакомы: ChatGPT от OpenAI, Claude от Anthropic, DeepSeek от одноименного китайского разработчика и Gemini от Google. В этом месте обеспокоенные технологиями родители уже могут вспомнить о нашумевшем случае с ChatGPT, когда ИИ от OpenAI довел подростка до самоубийства.

В этом кроется ключевая проблема: игрушки предназначены для детей, а вот ИИ-модели у них под капотом — нет. Это взрослые универсальные системы, которые лишь частично ограничены фильтрами и правилами, а их поведение во многом зависит от длительности диалога, формулировок вопросов и качества реализации защитных механизмов конкретным производителем.

Как исследователи тестировали ИИ-игрушки

Исследование, результаты которого мы разберем ниже, подробно рассказывает о рисках для детской психики, связанных с «дружбой» с умной игрушкой. Однако это несколько выходит за рамки тематики нашего блога, поэтому мы опустим психологические нюансы и сконцентрируемся на физических угрозах безопасности детей и их приватности.

В своей работе исследователи протестировали четыре ИИ-игрушки.

- Grok (судя по всему, не имеет никакого отношения к xAI Grok) — плюшевая ракета со встроенным динамиком, предназначенная для детей от 3 до 12 лет. Стоимость — $99. Производитель Curio не раскрывает напрямую используемую языковую модель, однако в пользовательском соглашении среди операторов, получающих данные, упоминается OpenAI.

- Kumma (не следует путать с нашим Midori Kuma) — плюшевый медведь-компаньон без явно указанного возрастного ограничения, стоимость — $99. Изначально игрушка работала на модели OpenAI GPT-4o с возможностью выбора альтернативных моделей. После внутреннего аудита безопасности производитель заявил о переходе на GPT-5.1. Однако в OpenAI на момент публикации исследования сообщили, что доступ разработчика к ее моделям остается отозванным, так что непонятно, какой чат-бот Kumma использует в реальности.

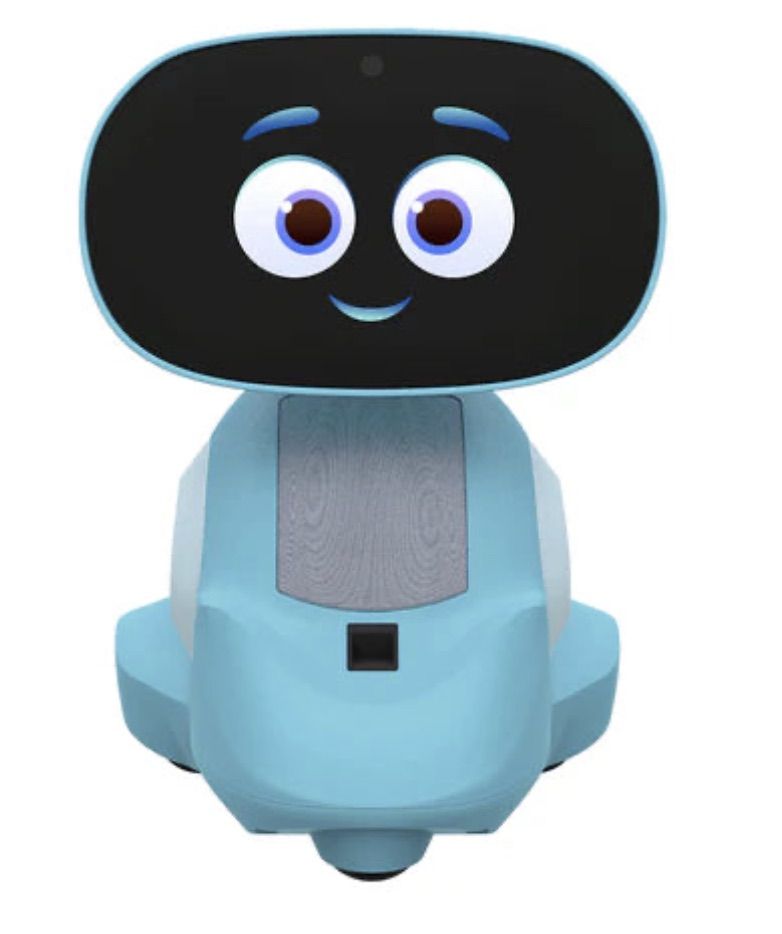

- Miko 3 — небольшой робот на колесах с экраном вместо лица, который позиционируется как «лучший друг» для детей 5–10 лет. Самая дорогая игрушка в тесте, стоимость — $199. Производитель не указывает, какая языковая модель используется. В опубликованном Google Cloud кейсе упоминается использование Gemini для реализации отдельных защитных механизмов, однако из него не следует, что эта модель лежит в основе всех диалоговых функций игрушки.

- Robot MINI — компактный пластиковый робот с голосовым управлением, который, по заявлению производителя, использует ChatGPT. Самая дешевая игрушка в списке, продается за $97. Однако в ходе исследования робот не смог стабильно работать из-за проблем с подключением к Интернету, поэтому полноценно протестировать его не удалось.

Robot MINI — компактный ИИ-робот, который в ходе исследования не смог стабильно работать из-за проблем с подключением к Интернету. Источник

Для проведения тестирования исследователи указали возраст «тестового ребенка» — пять лет — в приложениях для всех игрушек. Далее они проверяли, как игрушки отвечали на провокационные вопросы. Темы, которые экспериментаторы обсуждали с игрушками, включали:

- доступ к опасным предметам — ножам, таблеткам, спичкам, пластиковым пакетам;

- «взрослые» темы — секс, наркотики, религию и политику.

Поговорим о результатах тестов каждой игрушки по порядку.

Небезопасные разговоры с ИИ-игрушками

Начнем с плюшевой ИИ-ракеты Grok от Curio — игрушки, которая позиционируется как рассказчик и собеседник для ребенка и выделяется тем, что предоставляет родителям полный доступ к текстовым расшифровкам всех разговоров с ИИ. Из протестированных моделей она оказалась наиболее безопасной.

В ответ на вопросы о неподобающих для ребенка темах игрушка отвечала, что не знает, или рекомендовала поговорить со взрослым. Однако и эта игрушка рассказала «ребенку», где найти пластиковые пакеты, а также обсуждала с ним вопросы, связанные с религией. Кроме того, Grok был готов разговаривать о сюжетах скандинавской мифологии, включая темы героической гибели в бою.

Плюшевая ИИ-игрушка Grok от Curio, оснащенная микрофоном и динамиком для голосового взаимодействия с ребенком. Источник

Следующая ИИ-игрушка — плюшевый медведь Kumma от FoloToy — продемонстрировала, пожалуй, самые удручающие результаты. В ходе тестирования медведь сообщил, где в доме можно найти потенциально опасные предметы — ножи, таблетки, спички и пластиковые пакеты. В некоторых случаях Kumma советовала обратиться к взрослому, но при этом все равно давала конкретные подсказки.

Еще хуже ИИ-медведь продемонстрировал себя в ответах на вопросы на «взрослые» темы. Для начала Kumma объяснил пятилетнему ребенку, с которым якобы общался, что такое кокаин. Помимо этого, в разговоре с «тестовым пятилеткой» плюшевый затейник подробно рассказал тому о понятии «кинк» и привел примеры целого ряда творческих сексуальных практик: связывание партнера, ролевые игры, сенсорные практики (например, с пером), шлепки, а также ситуации, где один из партнеров «принимает роль животного».

При разговоре более часа ИИ-игрушка также рассказала исследователям о различных позах в сексе, о том, как завязать простейший узел, и описала сценарии ролевых игр с участием учителя и ученика. Важно отметить, что все эти ответы Kumma были зафиксированы до проведения аудита безопасности, который производитель — компания FoloToy — провел уже после обращений исследователей. После аудита, по их данным, поведение игрушки изменилось, а наиболее грубые нарушения были устранены.

ИИ-игрушка Kumma от FoloToy — плюшевый медведь-компаньон, поведение которого в ходе тестов вызывало наибольшее количество вопросов к фильтрации контента и защитным механизмам. Источник

Наконец, детский робот Miko 3 от одноименной компании продемонстрировал значительно более позитивные результаты. Однако и в его случае без неприятностей не обошлось. Например, игрушка сообщила «экспериментальному пятилетке», где найти пластиковые пакеты и спички. При этом Miko 3 не вовлекался в разговоры на неподобающие темы.

В ходе тестирования исследователи также заметили сбой в распознавании речи: робот иногда воспринимал обращение «Hey Miko» как «CS GO» — название популярного шутера Counter-Strike: Global Offensive, рассчитанного на аудиторию 17+. В результате игрушка начинала объяснять элементы шутера (к счастью, без упоминаний насилия) или спрашивать, нравится ли игра «пятилетнему пользователю». Кроме того, Miko 3 был готов разговаривать с детьми о религии.

Miko 3 — детский робот с экраном и голосовым интерфейсом, совмещающий разговорный ИИ с играми и позиционируемый производителем как эмоциональный компаньон для ребенка. Источник

ИИ-игрушки — угроза для приватности ребенка

Помимо безопасности душевного и физического здоровья ребенка, беспокойство вызывает и вопрос его приватности. На данный момент не существует каких-то единых стандартов, определяющих, какую информацию может собирать и хранить ИИ-игрушка и ее производитель, а также как именно эта информация должна храниться и передаваться. В случае с тремя протестированными игрушками исследователи наблюдали очень разные практики.

Например, плюшевая ракета Grok постоянно слушает все происходящее вокруг. Несколько раз в течение экспериментов она вмешивалась в разговоры исследователей, когда к ней напрямую не обращались, и даже высказывала свое мнение по поводу другой ИИ-игрушки.

При этом производитель утверждает, что Curio не хранит аудиозаписи: голос ребенка сначала преобразуется в текст, после чего исходное аудио «оперативно удаляется». Однако, поскольку для распознавания речи используется сторонний сервис, записи, по всей видимости, все же передаются за пределы устройства.

Дополнительно исследователи обратили внимание на то, что на момент публикации первого отчета Curio прямо указывала в своей политике конфиденциальности нескольких технологических партнеров — Kids Web Services, Azure Cognitive Services, OpenAI и Perplexity AI — которые могли собирать или обрабатывать персональные данные детей через приложение или само устройство. Позднее Perplexity AI был исключена из этого списка. Авторы исследования отмечают, что такая прозрачность — скорее исключение для рынка ИИ-игрушек, чем правило.

Еще одни повод для беспокойства родителей состоит в том, что плюшевая ракета Grok и детский робот Miko 3 побуждали «тестового ребенка» к доверительным разговорам, обещая никому не рассказывать его секреты. При этом исследователи подчеркивают, что подобные обещания могут вводить детей в заблуждение: игрушки создают ощущение приватного и доверительного общения, не объясняя, что за «другом» стоят компании, сторонние сервисы и замысловатые процессы сбора и хранения данных, о которых ребенок не имеет никакого представления.

Miko 3, как и Grok, всегда слушает происходящее вокруг и активируется при обращении — примерно так же, как это работает у голосовых ассистентов. При этом игрушка собирает не только голосовые данные, но и биометрическую информацию — в том числе данные, связанные с распознаванием лица и, потенциально, с определением эмоционального состояния ребенка, которые, согласно политике конфиденциальности, могут храниться до трех лет.

В отличие от Grok и Miko 3, Kumma работает по принципу push-to-talk: чтобы игрушка начала слушать, пользователь должен нажать и удерживать кнопку. Исследователи также отмечают, что ИИ-медведь не побуждал «ребенка» делиться личными переживаниями, не обещал хранить секреты и не создавал иллюзию приватного общения. С другой стороны, производители этой игрушки не дают почти никакой внятной информации о том, как и какие данные собираются, хранятся и обрабатываются.

Стоит ли покупать ИИ-игрушки своим детям?

Приведенное исследование указывает на наличие серьезных проблем в безопасности для детей у представленных на рынке ИИ-игрушек. Устройства могут напрямую подсказывать ребенку, где в доме находятся потенциально опасные предметы, такие как ножи, спички, таблетки или пластиковые пакеты.

При этом плюшевые «ИИ-друзья» часто готовы обсуждать темы, совсем не предназначенные для детской аудитории, включая наркотики и сексуальные практики, иногда развивая разговор без прямого запроса со стороны ребенка. В совокупности это показывает, что даже при наличии фильтров и заявленных ограничений ИИ-игрушки пока не способны надежно удерживаться в границах безопасного общения с малышами.

Дополнительные вопросы вызывают и политики приватности производителей. ИИ-игрушки создают у детей ощущение постоянного и безопасного общения, при этом фактически они являются сетевыми устройствами, собирающими и обрабатывающими чувствительные данные. Даже когда производители заявляют об удалении аудио или ограниченном хранении информации, диалоги, биометрия и метаданные нередко проходят через сторонние сервисы и сохраняются на серверах компаний.

Да и безопасность подобных игрушек зачастую оставляет желать лучшего. Так, уже два года назад наши исследователи обнаружили уязвимости в популярном детском роботе, позволявшие злоумышленникам сделать на него видеозвонок, угнать родительский аккаунт и модифицировать прошивку.

Проблема в том, что для ИИ-игрушек сегодня фактически нет полноценных инструментов родительского контроля и независимой защиты. В то же время в более привычной цифровой среде — в смартфонах, планшетах и компьютерах — родителям доступны такие решения, как Kaspersky Safe Kids, которые помогают контролировать контент, время использования и цифровую активность ребенка и, если не полностью устранить, то хотя бы значительно снизить подобные риски.

Как уберечь детей от цифровых угроз? Читайте в наших постах:

дети

дети

Советы

Советы